Что пишут в блогах

- Мы незаметно перескочили странную границу

- Книга «SQL. Курс молодого бойца» уже в продаже!

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

- Новогодний QA квиз

- Не просри свое время

- Гуру на Урале 4 декабря

Что пишут в блогах (EN)

- The Code You Can’t Delete

- AI and Testing: Personal Marketability

- Writing a recommendation

- Everyone is NOT Responsible for Quality

- My LinkedIn break - six weeks in

- AI and Testing: Scaling Tests

- When you outsource testing to the AI, you lose the ability to understand your system

- User Error (Update)

- The Box and The Arrow.

- Contraption.AI

Онлайн-тренинги

-

CSS и Xpath: инструменты тестировщикаНачало: 19 февраля 2026

-

Инженер по тестированию программного обеспеченияНачало: 19 февраля 2026

-

Азбука ITНачало: 19 февраля 2026

-

Тестирование GraphQL APIНачало: 19 февраля 2026

-

Python для начинающихНачало: 19 февраля 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 февраля 2026

-

Selenium IDE 3: стартовый уровеньНачало: 20 февраля 2026

-

Программирование на Python для тестировщиковНачало: 20 февраля 2026

-

Автоматизация тестирования REST API на JavaНачало: 25 февраля 2026

-

Автоматизация тестирования REST API на PythonНачало: 25 февраля 2026

-

Тестирование безопасностиНачало: 25 февраля 2026

-

Тестирование мобильных приложений 2.0Начало: 25 февраля 2026

-

Автоматизация тестов для REST API при помощи PostmanНачало: 26 февраля 2026

-

Применение ChatGPT в тестированииНачало: 26 февраля 2026

-

Школа для начинающих тестировщиковНачало: 26 февраля 2026

-

Практикум по тест-дизайну 2.0Начало: 27 февраля 2026

-

Тестирование производительности: JMeter 5Начало: 27 февраля 2026

-

Тестирование REST APIНачало: 2 марта 2026

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Школа тест-менеджеров v. 2.0Начало: 11 марта 2026

-

Bash: инструменты тестировщикаНачало: 12 марта 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 марта 2026

-

Docker: инструменты тестировщикаНачало: 12 марта 2026

-

Git: инструменты тестировщикаНачало: 12 марта 2026

-

Регулярные выражения в тестированииНачало: 12 марта 2026

-

SQL: Инструменты тестировщикаНачало: 12 марта 2026

-

Автоматизация функционального тестированияНачало: 13 марта 2026

-

Логи как инструмент тестировщикаНачало: 16 марта 2026

-

Техники локализации плавающих дефектовНачало: 16 марта 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 17 марта 2026

-

Школа Тест-АналитикаНачало: 18 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

-

Тестирование веб-приложений 2.0Начало: 20 марта 2026

-

Программирование на C# для тестировщиковНачало: 27 марта 2026

-

Аудит и оптимизация QA-процессовНачало: 3 апреля 2026

| Тестирование финтех бэкенда: как мы дошли до 20 тыс. тест-кейсов |

| 15.06.2022 00:00 |

|

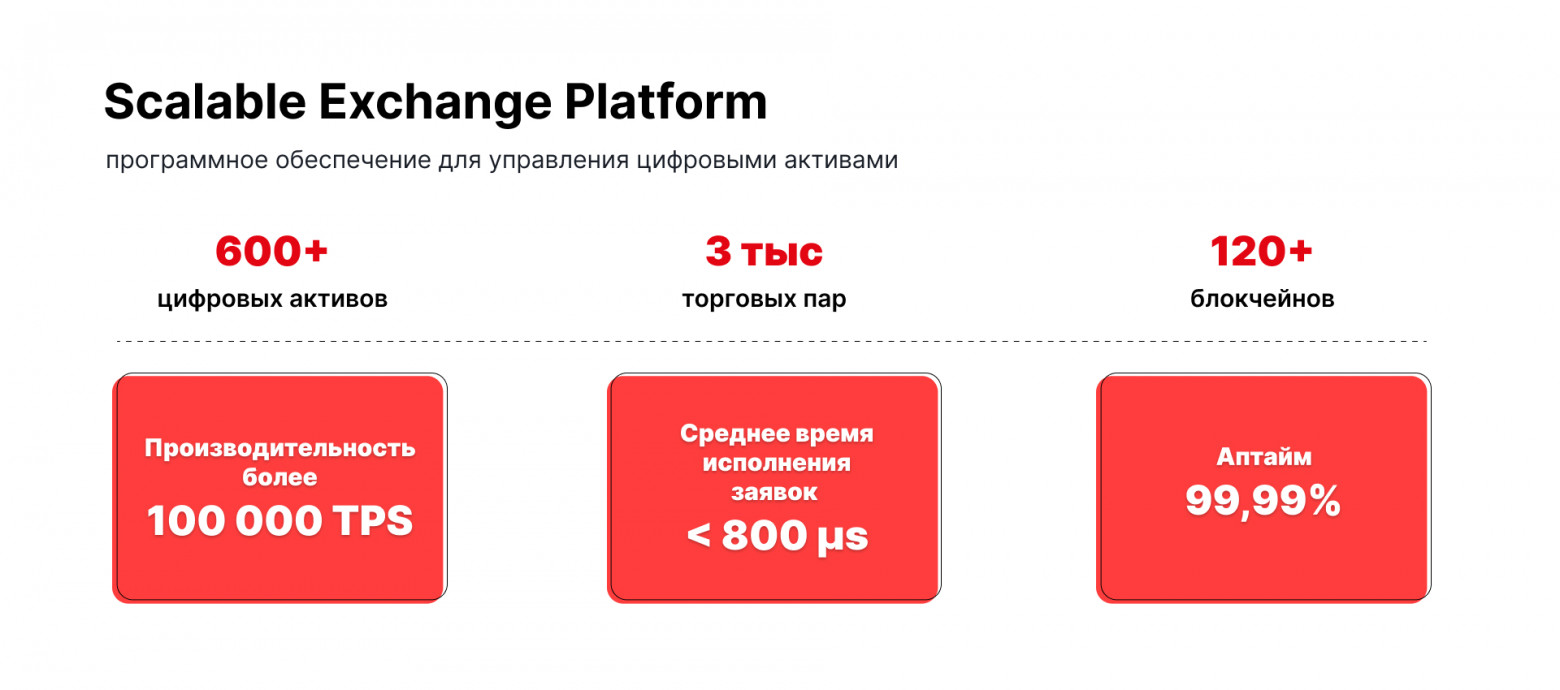

Привет, я Black из Scalable, QA Lead в команде бэкенда по разработке биржевого ядра. Так как уже долгое время занимаюсь развитием высоконагруженной платформы, решил написать о том, как нам удалось поставить QA-процесс с 20 000 тест-кейсов, создать гибкую инфраструктуру для автоматизированного тестирования в нескольких типах API, включая асинхронные бинарные протоколы, и пройти путь разработки от отладочных утилит до специализированных тестовых фреймворков для интеграционного и компонентного тестирования. Биржевое ядро Это ядро криптовалютной биржи (бэкенд), которое является ключевым компонентом платформы Scalable Exchange. Отмечу, что мы не криптобиржа, а разработчик трейдинговой инфраструктуры для создания криптобирж. Наше биржевое ядро построено на микросервисной архитектуре и состоит из 30-ти с лишним компонентов, которые смасштабированы более чем на 100 серверах в нескольких дата-центрах мира. На сегодняшний день у нас зарегистрировано более 5 млн пользователей. Средняя частота размещения заявок составляет 100т./сек. Платформа позволяет работать с более чем шестью сотнями цифровых активов и тремя тысячами торговых пар на 120 блокчейнах. И это все работает для торговли спотового, маржинального и фьючерсного типа.

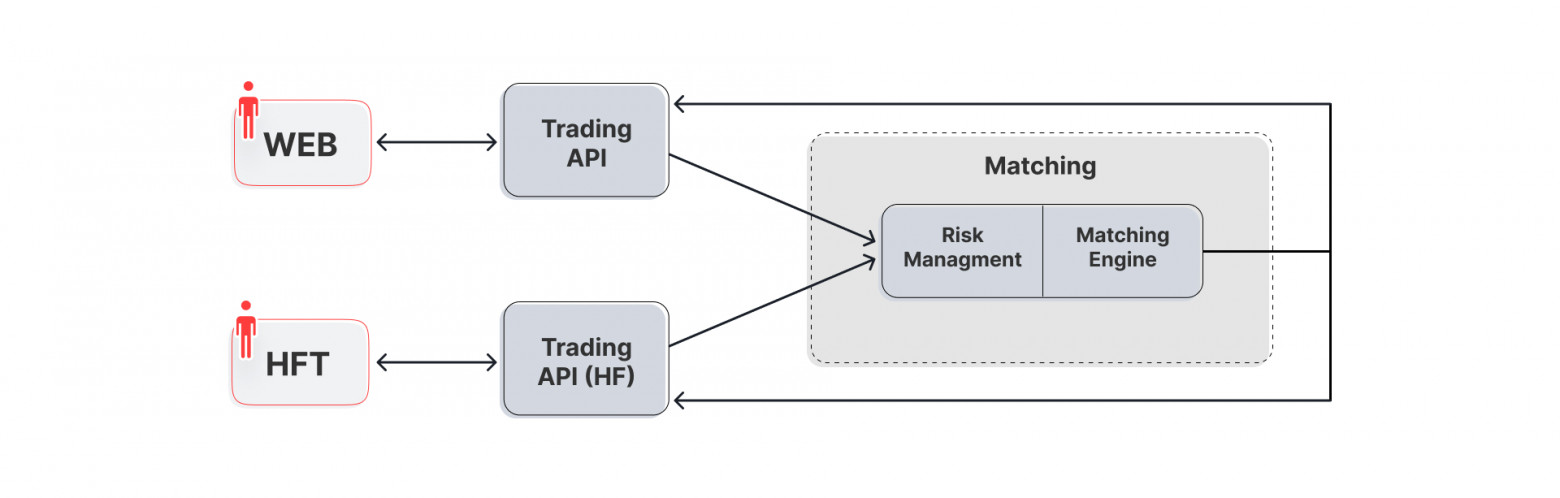

Концептуальная схема ядра Биржевое ядро можно разделить на несколько блоков:

Казалось бы, объект тестирования прозрачен и понятен – есть точки входа для пользователя и администратора. Генерим тестовые данные в виде заявок на вход торговых гейтов, собираем ответы, сверяем с ожидаемым результатом. Классическая схема тестирования. Однако заглядывая глубже в архитектуру системы выясняется, что торговать можно и нужно на различных типах гейтов, а данные о происходящем на рынке собирать различными способами. Специфика бизнес-логикиОсновная бизнес-логика разбита на 2 части:

Тестирование бизнес логики системы представляет собой довольно сложную задачу. Как правило, она сводится к задаче условного моделирования, где необходимо применить мат.модели и подготовить данные для тестирования, провести требуемую тестовую логику, собрать результаты с целевых компонентов, подтвердить корректность и консистентность работы всей системы в целом. Дополнительным усложнением при тестировании являются race conditions, провоцируемые как горизонтальным масштабированием системы, так и наличием проактивных компонентов.

Также к бизнес-логике биржевой системы предъявляется ряд нефункциональных требований по:

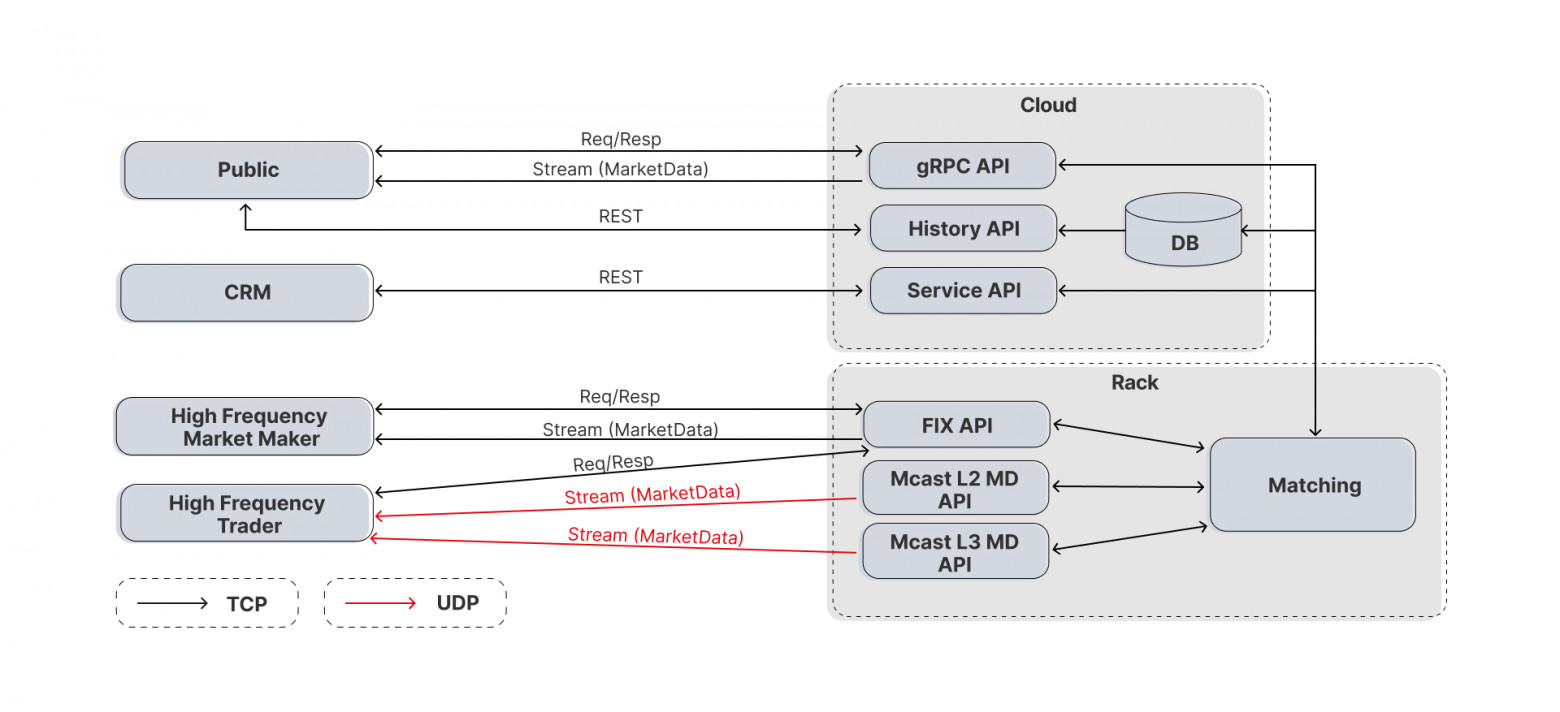

Детализация ядраНа сегодняшний день практически любая торговая система поддерживает разнообразные способы подключения для отправки запросов и сбора данных. Наша система не стала исключением. Для постановок заявок используются два вида торговых гейтов:

Маркетдатные гейты, отвечающие за публикацию рыночных данных, представлены еще большим разнообразием с аналогичной историей. Каждый маркетдатный гейт имеет свою структуру, свой протокол, свою специфику. Строгость требования между gRPC и FIX гейтами схожа (как у торговых), а вот формат ответов будет различаться. Они делятся на два типа: L3 – где пользователю обезличенно отправляются все события по каждой заявке на рынке, и L2 – где данные отправляются с агрегацией по цене за определенный период. Маркетдатные гейты также имеют свою специфику по транспорту. Например, помимо гейтов использующих протоколы ТСР, есть гейты раздающие маркет дату через UDP multicast.

Виды пользователей Отдельно стоит рассказать про типы торговых пользователей в системе, так как разные пользователи дают разную нагрузку. Публичные клиенты. Это пользователи, которые торгуют через WEB-интерфейс, мобильные приложения и REST. Таких клиентов большинство, около 5 млн. При этом одновременно торгуют обычно несколько сотен тысяч. Данный тип клиентов дает небольшую нагрузку, до нескольких тысяч RPS. Высокочастотные трейдеры. Это, как правило, индустриальные трейдинговые платформы, которые работают по определенной стратегии – арбитраж, маркет-мейкинг, краткосрочная торговля и др. Таких пользователей существенно меньше, около сотни, но при этом каждый такой робот может генерировать десятки тысяч RPS. Гейты для первых, как правило, находятся в облаках и не имеют строгих требований к производительности. На сегодняшний день latency (время отклика) для данных гейтов составляет 50 миллисекунд. Гейты для высокочастотных трейдеров находятся в стойке для обеспечения минимального времени отклика. Эта часть системы имеет требования к времени отклика до 500 микросекунд. А также дополнительные требования к производительности каждого отдельного компонента, стоящего на нагруженном пайплайне.

Выбор инструментов для тестирования Итак, количество точек входа/выхода значительно увеличилось, и появились специализированные требования к системе. Очевидно, что каждый компонент имеет свою строгую спецификацию и особенности работы.

Как видно, система не очень дружелюбная для ручных тестов. Поэтому приоритетной целью стало закрыть весь текущий функционал автоматизированными тестами. Три года назад в качестве инструментов QA отдела были только отладочные утилиты написанные на Python, через которые разработчики подключались к ядру для выполнения минимальных точечных ручных проверок. Поэтому в первую очередь, необходимо было определить технологический стек, на котором будет строиться тестовый проект. Критерии были следующими:

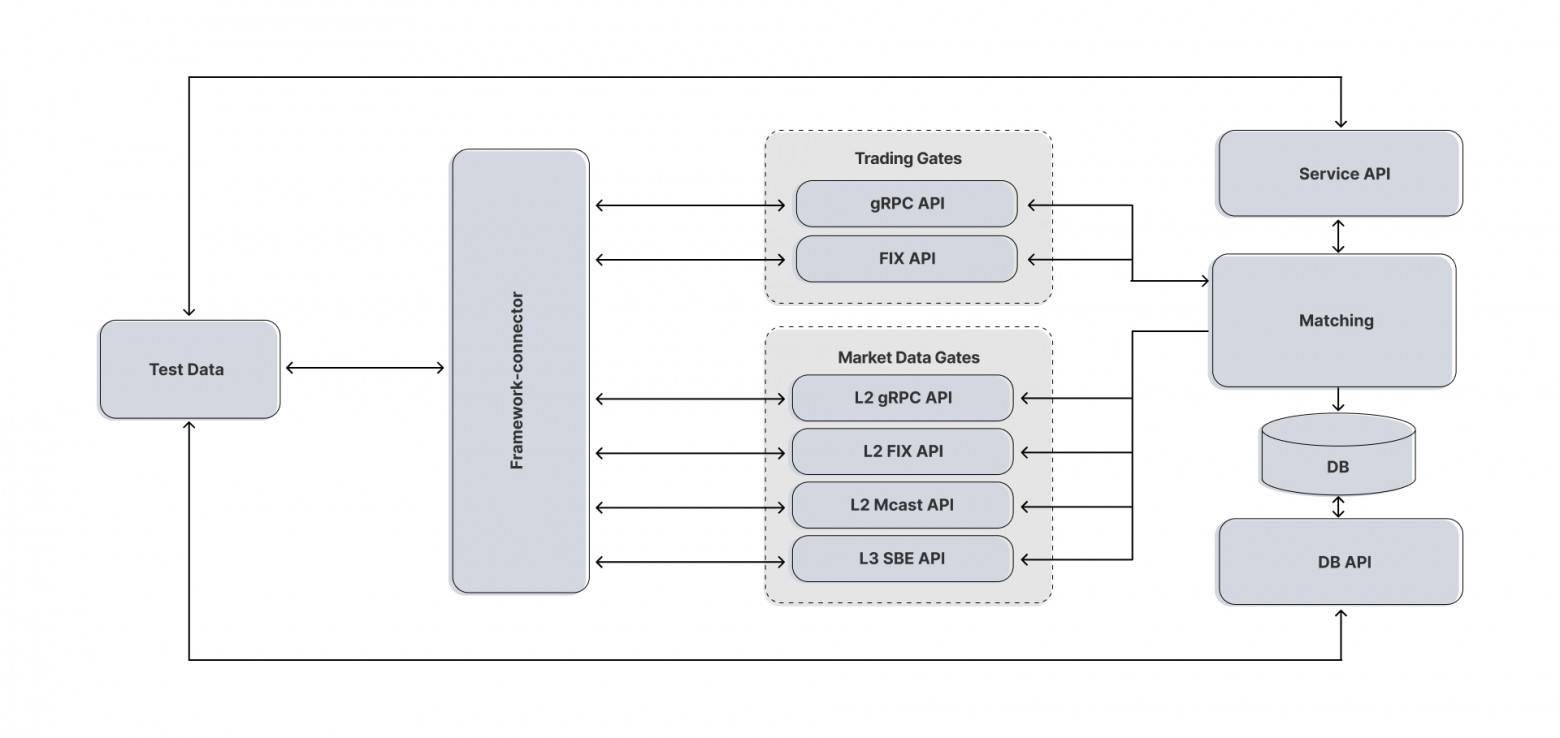

В результате родился привычный «джентльменский набор» Python + PyTest. Тестовый фреймворк как агрегаторСледующим встал вопрос, каким образом тестам работать на различных финансовых протоколах и как собирать ответы. Каждый компонент принимает запросы в своем формате, по своей спецификации и по своему протоколу, соответственно, отдает ответы так же. Плюс к этому, в некоторых протоколах применена скрытая служебная логика обмена сообщениями с клиентом.

Для обеспечения единого формата входных и выходных данных между тестом и тестируемой системой, в независимости от протоколов и прочих условий, требуется некий конвертер, который мог бы преобразовывать запросы в требуемый формат и отправлять их. Для этого был разработан фреймворк-коннектор. В его задачи входит:

Вся тестовая логика в дальнейшем работает через такие внутренние объекты, что позволяет тестам гибко работать с данными вне зависимости от какого гейта они были получены. Таким образом, тест на уровне фикстуры подключается к фреймворку, отправляет запрос в привычном json-формате, в ответ получает репорт в виде объекта.

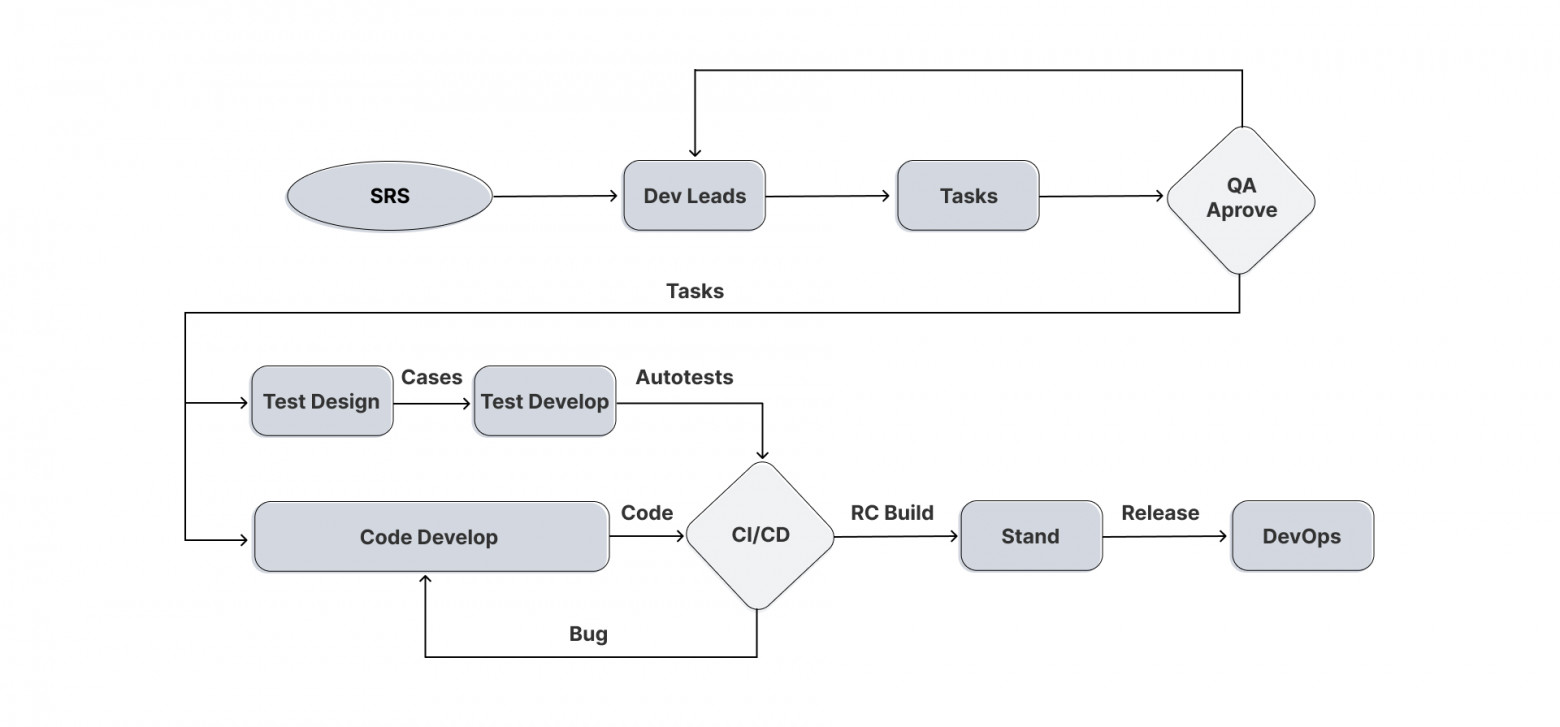

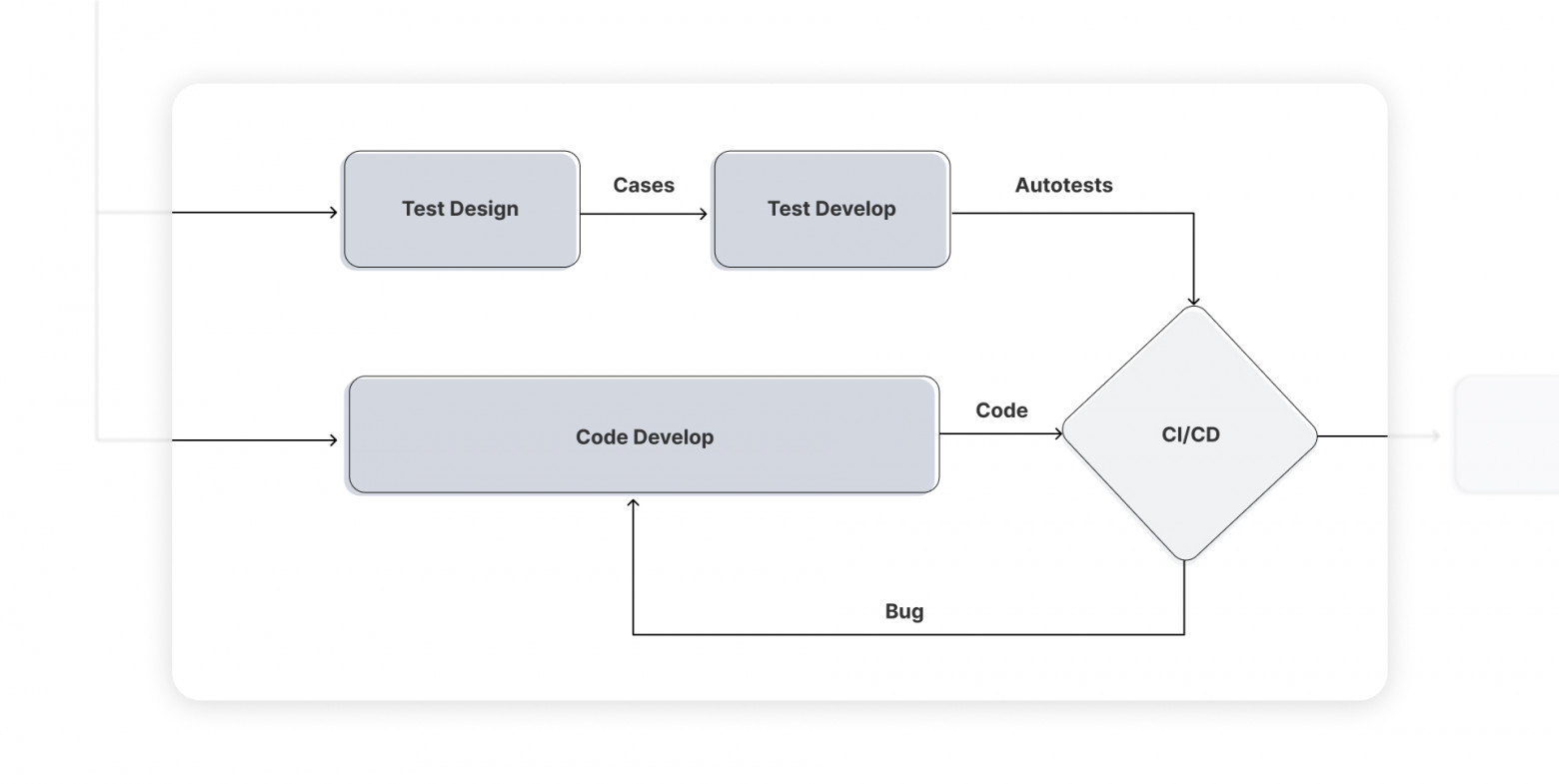

Данное решение позволило унифицировать тестовую дату на входе теста к одному виду. Под капотом спрятались низкоуровневые запросы к гейтам и обертки во внутренние типы для ответов. Предварительная проработка фичейПеред разработкой фичи и тест-кейсов, технические требования обязательно проходят проверку на адекват – полнота, достижимость, корректность. Если фича разработана, но тестами до нее не добраться или потребуется полгода писать тест, стоит задуматься нужна ли фича в таком виде в системе. Только после получения аппрува всеми командами начинается ее разработка. Расписываются тест-кейсы, определяется перечень необходимых вспомогательных функций, описываются мат. модели для расчета параметров, используемых в новой фиче, и т.п. Пишется код ядра, разрабатываются автотесты, после мержа выполняется прогон тестов в GitLab/CI. После прохождения всех тестов появляется релиз-кандидат, который уходит на стендовое тестирование, где проверяется производительность, миграция системы в обе стороны и дополнительные необходимые тесты(если требуется). Далее билд передается команде DevOps, которые разворачивают систему на проде.

Отмечу важный этап в нашем процессе – прогон полного цикла тестов. Он автоматически выполняется перед любым мерджем в ветку Develop или Master. Успешное прохождение всех тестов обязательно как для разработчиков, так и для QA-инженеров. Выглядит это следующим образом: в GitLab/CI запускается отдельный пайплайн, на удаленных машинах под гипервизорами поднимаются 140 независимых тестовых окружений, тесты делятся на группы и запускаются параллельно.

Именно в этом узле (на схеме сверху) появляется элемент параллельности или самостоятельности разработки. К примеру, разработчик ядра выполняет плановый рефакторинг системы. Он пушит свои изменения, которые никак не должны повлиять на бизнес-логику. Но после прогона в CI завалились тесты, которые проверяли компоненты, где разработчик даже не работал. Совместимость поломана, разработчик читает асерт, уходит на штрафной круг и добивается прохождения всех тестов. Причем уходит он самостоятельно, не привлекая дополнительные трудовые ресурсы коллектива. Разработка тест-кейсовНакопив довольно большой пул тестов, мы обратили внимание, что он поделился на два типа. Это функциональные и use-кейсы. Причем в зависимости от фичи, перевес количества тестов часто склонялся в сторону use-кейсов. Это связано с тем, что стандартные действия с системой уже покрыты тестами. Поэтому для новой фичи первоначальные действия уже проверены, и мы доверяем этим тестам. Остается проверить только новые изменения в системе, которые принесла фича. Например, в тесте на размещение нового типа заявки QA-инженеру достаточно построить из готовых “кубиков-функций” основную логику теста, и в нужном месте написать дополнительные проверки для новой фичи.

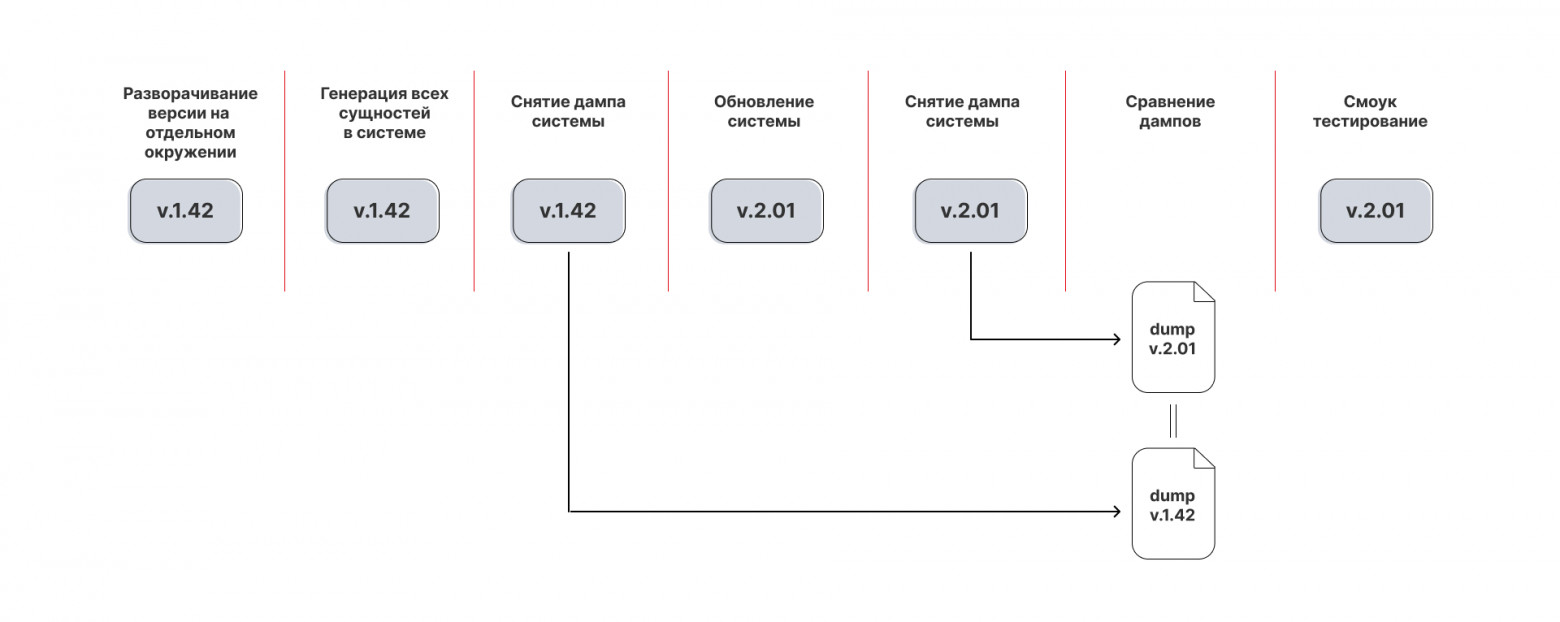

Рекавери и миграция Важной составляющей стали тесты на проверку восстановления системы и миграционные тесты. Если система не обеспечивает целостность накопленных данных при перезапусках, зачем вообще нужна такая система? Первые, рекавери тесты, обеспечивают проверку корректного восстановления системы после перезапуска компонентов. Миграционные тесты используются для проверки совместимости компонентов различных версий между собой. Также проверяется прямая миграция системы, включая все стораджи и БД, и обратная миграция в случае отката системы. Для этого вида тестирования используется специальный миграционный стенд. При подготовке релиза достаточно указать, с какой версии и на какую необходимо выполнить миграцию, далее в автоматизированном режиме в отдельном окружении разворачивается система, с помощью заранее написанных тестовых функций генерируются все возможные сущности системы. Снимаются дампы со всех стораджей, выполняется обновление версий компонентов, далее снимаются дампы уже с новой версии и сравниваются со старой. Таким образом обеспечивается полная совместимость версий при обновлении системы.

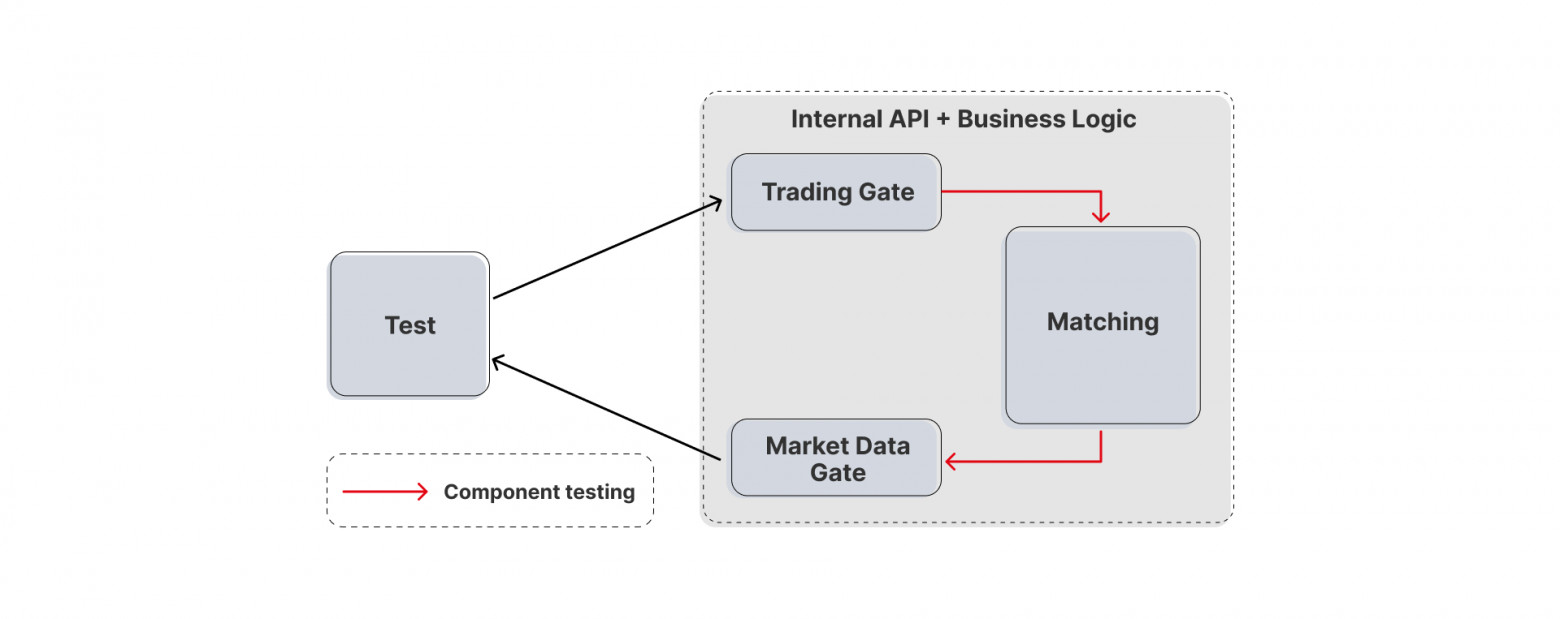

Компонентные тесты Проверяется ли матчинг без влияния на него периферийных компонентов? Потребность в таких тестах действительно есть. Что будет, если от имени торгового гейта кинуть запрос на размещение новой заявки с невалидными параметрами? Сейчас вся валидация такого рода проверяется на входе торгового гейта, и в матчинг поломанный запрос попасть никак не может. Однако безопасность работы матчинга должна быть проверена, так как это главный «орган» системы. Торговый гейт и матчинг общаются между собой по внутреннему протоколу. Внешним пользователям к данному компоненту подключиться невозможно. Для проверки подобных кейсов разработаны компонентные тесты по классической схеме. Тестируемый компонент, матчинг, изолируется от остальных. Мокируются связанные компоненты, которые участвуют в кейсе (в нашем случае это торговый гейт). И уже как бы от его имени отправляются запросы в матчинг. Подобные тесты, как правило, короткие и не требуют много времени на разработку. Однако подготовка инфраструктуры для них весьма затратна – иногда нужно писать большие куски системы, которые бы по-настоящему имитировали общение замокируемых компонентов с тестируемым компонентом.

Нагрузочные тесты Нагрузочные тесты, наверное, всегда вызывают боль. Поэтому стоит относиться со скептицизмом с подобным установкам:

Оценка покрытия системы тестамиНаверное, для любого проекта важна метрика оценки качества тестирования, представляющая из себя плотность покрытия тестами требований либо исполняемого кода. Наш проект не стал исключением. Покрытие тестами функциональных и нефункциональных требований может оставить непроверенными некоторые участки кода, потому что не учитывает конечную реализацию. В нашем проекте мы использовали инструмент LCov, который позволяет проанализировать, в какие строки кода системы были вхождения во время проведения тестирования. Результаты анализа позволили выявить дыры в покрытии, а также избавиться от дублирующих тестов.

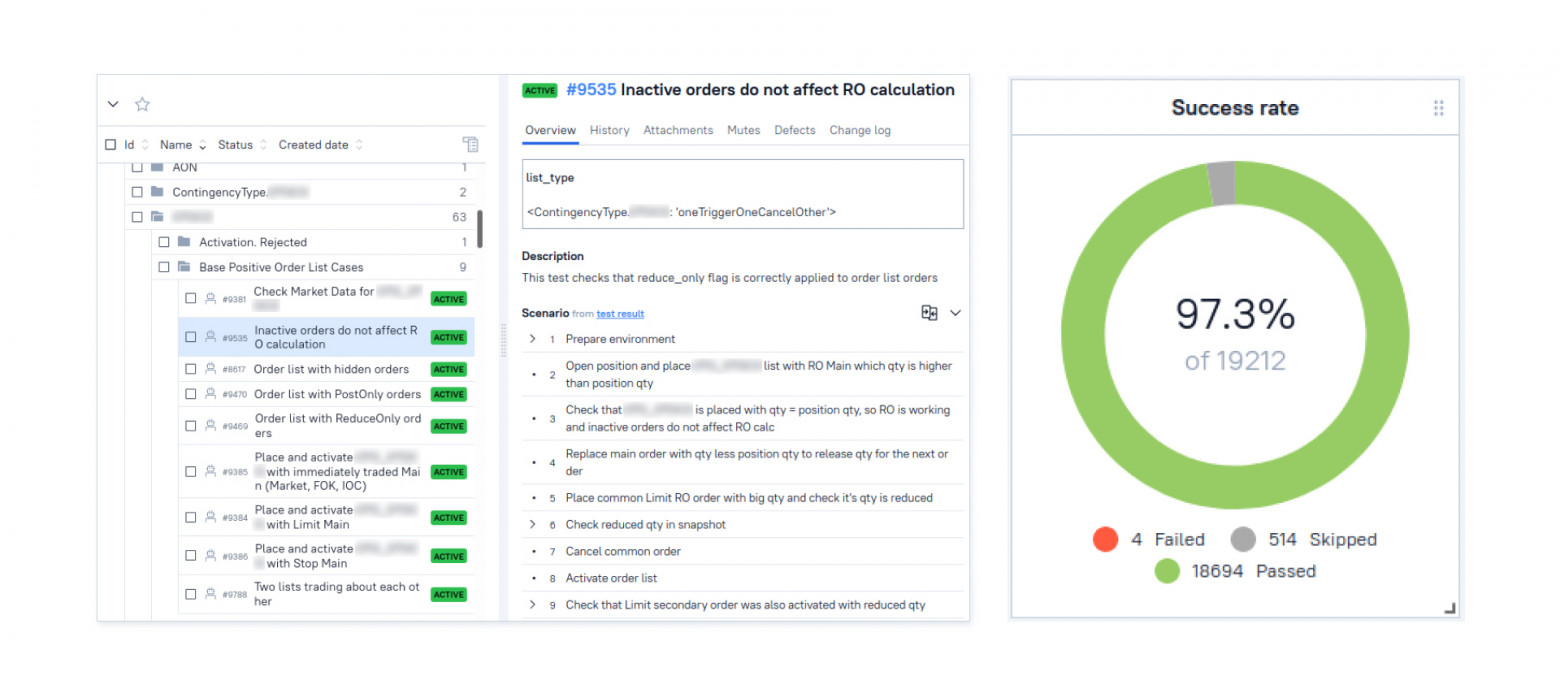

Результаты Результаты нашей работы за три года выглядят так – вот-вот перешагнем 20к тест-кейсов.

Понятно, что при таком огромном количестве тестов требуется внимательно следить за тестовой документацией. Чтобы не получилось ситуация, когда тесты пишутся ради тестов. При оформлении теста обязательно соблюдается трассировка: таска – тест-кейс – тест (Allure). В Allure есть возможность актуализировать тест-кейс из исходников теста, что значительно облегчает бюрократическую работу с тестовой документацией. Благодаря автоматизации в CI + отчетности в Allure, разработчик системы или QA-инженер легко может встать в отчете на упавший тест, из теста выйти в тест-кейс, а из него перейти к прямым требованиям к системе. В такой схеме локализация бага выполняется очень быстро. Безусловно, были и проблемы, с которыми мы неожиданно столкнулись во время работы.

Так система постоянно находится под постоянным автоматическом регрессом и этим обеспечивается высокое качество для сложного программного продукта. |