Что пишут в блогах

- 1 тест = 1 проверка. Чем хорош принцип атомарности в автотестах в Postman

- Новый функционал? Подождем до последнего. Как банки к АУСН подключались

- Хочешь ещё быстрее?

- Мы незаметно перескочили странную границу

- Книга «SQL. Курс молодого бойца» уже в продаже!

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

Что пишут в блогах (EN)

- AI and Testing: Improving Retrieval Quality, Part 3

- AI and Testing: Improving Retrieval Quality, Part 2

- AI and Testing: Improving Retrieval Quality, Part 1

- Requirements lead into worse testing?

- AI and Testing: Contextual Precision

- Benchmarking results - Human, Human with AI, AI with Human and where we land

- AI and Testing: Faithfulness

- So, You “10x’d” Your Work…

- AI and Testing: Answer Relevancy

- AI and Testing: Evaluation and DeepEval

Онлайн-тренинги

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Школа тест-менеджеров v. 2.0Начало: 11 марта 2026

-

Bash: инструменты тестировщикаНачало: 12 марта 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 марта 2026

-

Docker: инструменты тестировщикаНачало: 12 марта 2026

-

Python для начинающихНачало: 12 марта 2026

-

SQL: Инструменты тестировщикаНачало: 12 марта 2026

-

Git: инструменты тестировщикаНачало: 12 марта 2026

-

Азбука ИТНачало: 12 марта 2026

-

Школа для начинающих тестировщиковНачало: 12 марта 2026

-

Регулярные выражения в тестированииНачало: 12 марта 2026

-

Автоматизация функционального тестированияНачало: 13 марта 2026

-

Логи как инструмент тестировщикаНачало: 16 марта 2026

-

Тестирование REST APIНачало: 16 марта 2026

-

Техники локализации плавающих дефектовНачало: 16 марта 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 17 марта 2026

-

Школа Тест-АналитикаНачало: 18 марта 2026

-

CSS и Xpath: инструменты тестировщикаНачало: 19 марта 2026

-

Тестирование GraphQL APIНачало: 19 марта 2026

-

Инженер по тестированию программного обеспеченияНачало: 19 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

-

Автоматизация тестов для REST API при помощи PostmanНачало: 19 марта 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 марта 2026

-

Применение ChatGPT в тестированииНачало: 19 марта 2026

-

Тестирование веб-приложений 2.0Начало: 20 марта 2026

-

Автоматизация тестирования REST API на PythonНачало: 25 марта 2026

-

Автоматизация тестирования REST API на JavaНачало: 25 марта 2026

-

Тестирование безопасностиНачало: 25 марта 2026

-

Тестирование мобильных приложений 2.0Начало: 25 марта 2026

-

Программирование на C# для тестировщиковНачало: 27 марта 2026

-

Selenium IDE 3: стартовый уровеньНачало: 3 апреля 2026

-

Аудит и оптимизация процессов тестированияНачало: 3 апреля 2026

-

Программирование на Python для тестировщиковНачало: 3 апреля 2026

-

Тестирование производительности: JMeter 5Начало: 10 апреля 2026

-

Практикум по тест-дизайну 2.0Начало: 10 апреля 2026

| Нагрузочное тестирование с locust. Часть 2 |

| 01.03.2019 00:00 |

|

Для тех, кому понравилась предыдущая статья Алексея Остапова, продолжаем публикацию его статей об инструменте для нагрузочного тестирования Locust.

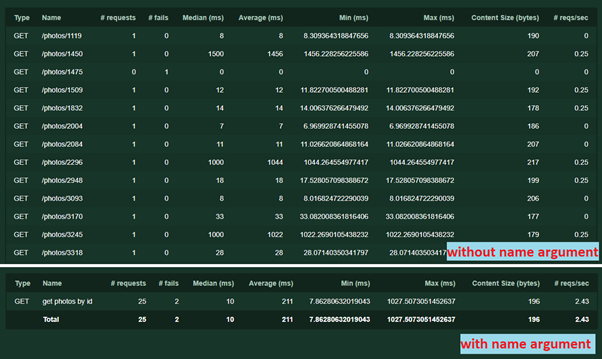

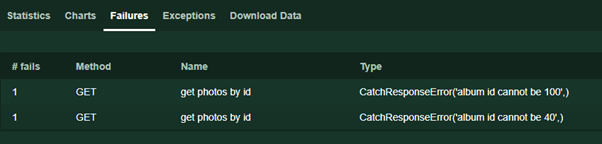

Обработка ответов сервераИногда в нагрузочном тестировании недостаточно просто получить от сервера HTTP 200 OK. Случается, надо еще проверить содержимое ответа, чтобы убедится, что под нагрузкой сервер выдает правильные данные или проводит точные вычисления. Как раз для таких случаев в Locust добавили возможность переопределять параметры успешности ответа сервера. Рассмотрим следующий пример:

С сервера мы запрашиваем объекты photos со случайными id в диапазоне от 1 до 5000 и проверяем в этом объекте id альбома, предполагая, что он не может быть кратным 10 Тут сразу же можно дать несколько пояснений:

Работа со сложными сценариямиПочти каждый раз, когда ставится задача провести нагрузочное тестирование веб приложения, быстро становится ясно, что нельзя обеспечить достойное покрытие одними только GET сервисами — которые просто возвращают данные.

Из примера можно предположить, что вызывать сервисы в случайном порядке не получится, только последовательно. Более того, у товаров, корзины и формы оплаты могут быть уникальные для каждого пользователя идентификаторы.

В этом примере я добавил новый класс FlowException. После каждого шага, если он прошел не так, как ожидалось, я выбрасываю этот класс исключения, чтобы прервать сценарий — если пост создать не получилось, то нечего будет комментировать и т.д. При желании, конструкцию можно заменить обычным return, но в таком случае, во время исполнения и при анализе результатов будет не так хорошо видно, на каком шаге падает выполняемый сценарий на вкладке Exceptions. По этой же причине, я не использую конструкцию try… except. Делаем нагрузку реалистичнойСейчас меня можно упрекнуть — в случае с магазином все действительно линейно, но пример с постами и комментами слишком притянут за уши — читают посты раз в 10 чаще, чем создают. Резонно, давайте сделаем пример более жизненным. И тут есть минимум 2 подхода:

В классе UserBehavior я создал список created_posts. Обратите особое внимание — это объект и он создан не в конструкторе класса __init__(), поэтому, в отличии от клиентской сессии, этот список — общий для всех пользователей. Первая задача создает пост и записывает его id в список. Вторая — в 10 раз чаще, читает один, случайно выбранный, пост из списка. Дополнительным условием второй задачи является проверка, есть ли созданные посты. Еще немного возможностейДля последовательного запуска задач официальная документация предлагает нам также использовать аннотацию задач @seq_task(1), в аргументе указывая порядковый номер задачи

|