Что пишут в блогах

- Гуру на Урале 4 декабря

- Мои 12 недель в году. Часть 32 (ДР Влада и мой, болезни...)

- Опрос удовлетворенности работой 2025

- DB Fiddle — бесплатная SQL песочница!

- Митап в Т-Банке 20 ноября

- Как яндекс диск сдох при одновременном перемещении папки

- ChatGPT для общения с англоязычной техподдержкой

- Книга: Лидер и племя. Дэйв Логан, Джон Кинг, Хэли Фишер-Райт

- Панбагон. Ошибка печати в кассе, когда ленты нет, но стоит галка "не печатать чек"

- ПОТ перешел на индивидуальный формат

Что пишут в блогах (EN)

- “Slop Coding” and Responsible Testers

- Guarding Quality From Drift to Discipline

- The Book is Here

- Report on Testival Meetup #76, qa in the era of ai and vibe coding

- Serious Data From Testing LLMs

- 10 Tips for Writing Playwright Tests with Cursor

- Seriously Testing LLMs

- Using Narratives to Sharpen Testing Skills

- 2FA testing with Playwright and Mailosaur

- Lessons from nature to improve how we work

Онлайн-тренинги

-

Программирование на Java для тестировщиковНачало: 28 ноября 2025

-

Автоматизация функционального тестированияНачало: 28 ноября 2025

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 2 декабря 2025

-

Charles Proxy как инструмент тестировщикаНачало: 4 декабря 2025

-

CSS и Xpath: инструменты тестировщикаНачало: 4 декабря 2025

-

Python для начинающихНачало: 4 декабря 2025

-

Азбука ITНачало: 4 декабря 2025

-

Тестирование GraphQL APIНачало: 4 декабря 2025

-

Инженер по тестированию программного обеспеченияНачало: 4 декабря 2025

-

Аудит и оптимизация QA-процессовНачало: 5 декабря 2025

-

Тестирование веб-приложений 2.0Начало: 5 декабря 2025

-

Логи как инструмент тестировщикаНачало: 8 декабря 2025

-

Тестирование REST APIНачало: 8 декабря 2025

-

Автоматизатор мобильных приложенийНачало: 10 декабря 2025

-

Автоматизация тестирования REST API на JavaНачало: 10 декабря 2025

-

Автоматизация тестирования REST API на PythonНачало: 10 декабря 2025

-

Тестирование безопасностиНачало: 10 декабря 2025

-

Тестирование мобильных приложений 2.0Начало: 10 декабря 2025

-

Применение ChatGPT в тестированииНачало: 11 декабря 2025

-

Школа для начинающих тестировщиковНачало: 11 декабря 2025

-

Автоматизация тестов для REST API при помощи PostmanНачало: 11 декабря 2025

-

Программирование на C# для тестировщиковНачало: 12 декабря 2025

-

Школа Тест-АналитикаНачало: 17 декабря 2025

-

Школа тест-менеджеров v. 2.0Начало: 17 декабря 2025

-

Selenium IDE 3: стартовый уровеньНачало: 19 декабря 2025

-

Программирование на Python для тестировщиковНачало: 19 декабря 2025

-

Bash: инструменты тестировщикаНачало: 15 января 2026

-

Docker: инструменты тестировщикаНачало: 15 января 2026

-

Git: инструменты тестировщикаНачало: 15 января 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 15 января 2026

-

SQL: Инструменты тестировщикаНачало: 15 января 2026

-

Регулярные выражения в тестированииНачало: 15 января 2026

-

Организация автоматизированного тестированияНачало: 16 января 2026

-

Практикум по тест-дизайну 2.0Начало: 16 января 2026

-

Тестирование производительности: JMeter 5Начало: 16 января 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 19 января 2026

-

Техники локализации плавающих дефектовНачало: 19 января 2026

-

Создание и управление командой тестированияНачало: 22 января 2026

| Как мы автоматизировали запуск Selenium-тестов через Moon и OpenShift |

| 10.04.2019 00:00 |

|

14 декабря на митапе в Санкт-Петербурге я (Артем Соковец) совместно с коллегой, Дмитрием Маркеловым, рассказывал о текущей инфраструктуре для автотестов в СберТехе. Пересказ нашего выступления — в этом посте. Что такое SeleniumSelenium — это инструмент для автоматизации действий веб-браузера. На сегодня данный инструмент является стандартом при автоматизации WEB.

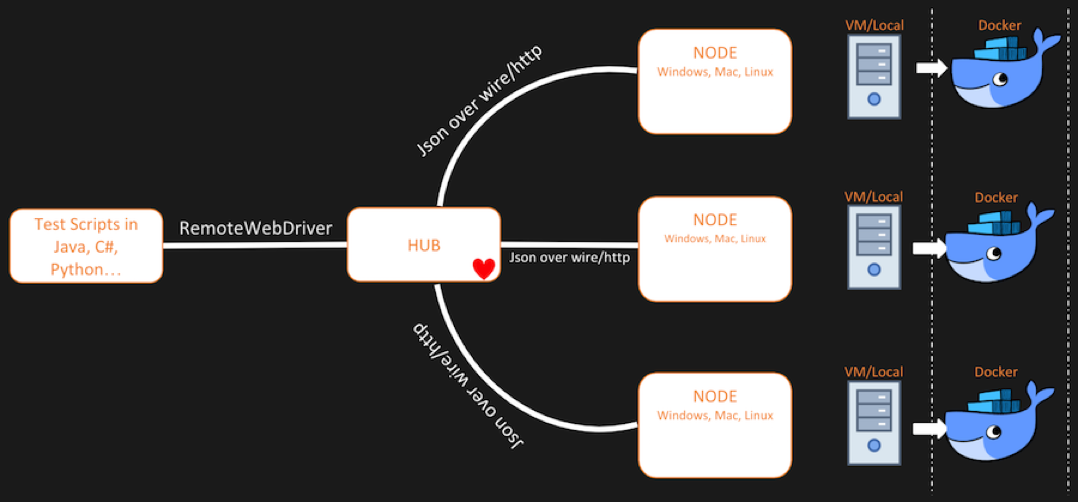

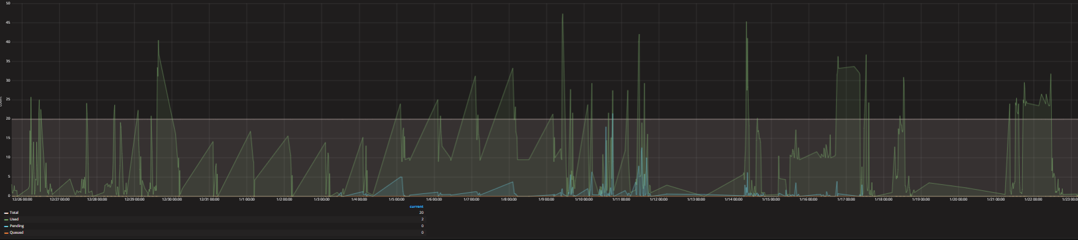

Selenium GRID

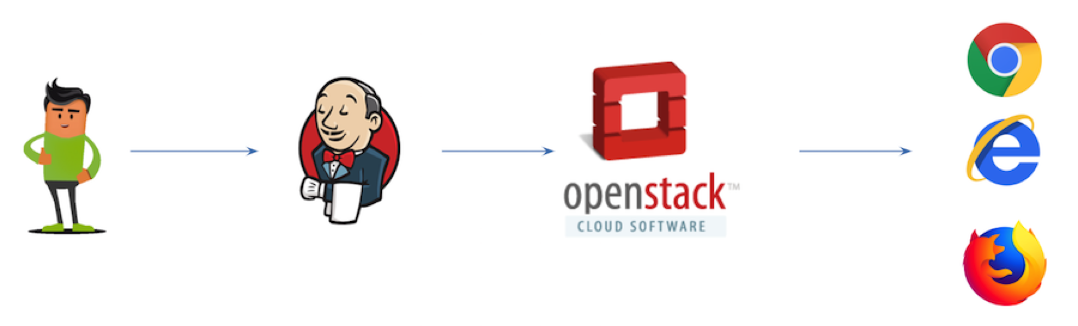

Первоначальная инфраструктура автотестов в СберТехеРанее в СберТехе была следующая инфраструктура для UI-автотестов. Пользователь запускал сборку на Jenkins-е, который с помощью плагина обращался в OpenStack за выделением виртуальной машины. Происходило выделение ВМ со специальным «образом» и нужным браузером, и только затем на этой ВМ выполнялись автотесты. Требования к новой инфраструктуреПосещая различные конференции по автоматизации, разработке и DevOps (Heisenbug, SQA Days, CodeOne, SeleniumConf и другие) у нас постепенно формировался список требований к новой инфраструктуре:

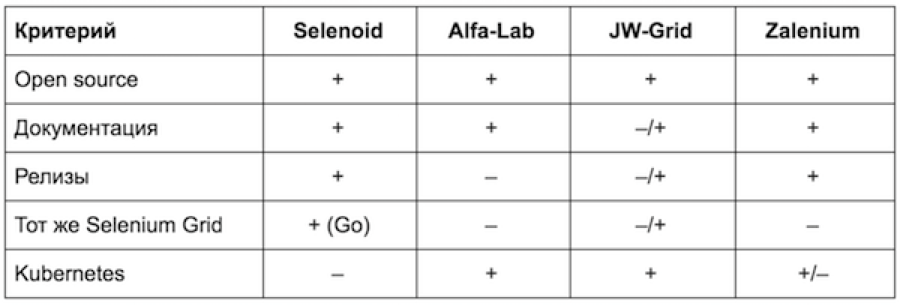

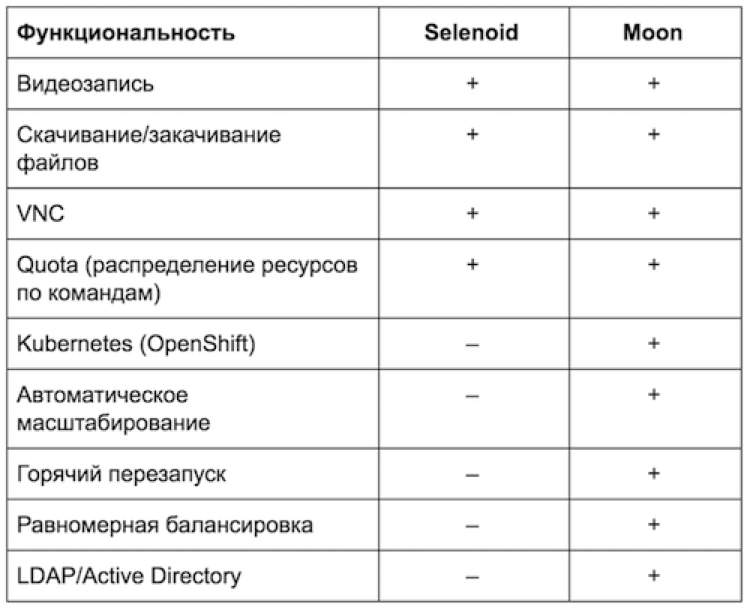

Краткий обзор существующих решенийОпределившись с задачами, мы проанализировали существующие на рынке решения. Основное, что мы рассмотрели, — продукты команды Aerokube (Selenoid и Moon), решения Alfalab (Альфа Лаборатория), JW-Grid (Авито) и Zalenium. Selenoid vs MoonЧетыре месяца мы использовали Selenoid при автоматизации экосистемы Сбербанка. Это неплохое решение, но Банк движется в сторону OpenShift, а развернуть Selenoid в OpenShift нетривиальная задача. Тонкость в том, что Selenoid в Kubernetes управляет докером последнего, а Kubernetes про это ничего не знает и не может правильно шедулить другие ноды. Кроме того, для Selenoid в Kubernetes требуется GGR (Go Grid Router), в котором хромает распределение нагрузки. Инфраструктура автотестовНынешняя инфраструктура с использованием Moon и OpenShift выглядит следующим образом: Запуск Internet ExplorerКонечно, не обошлось без сложностей. Как ранее говорилось, целевым браузером для нас является Internet Explorer — большинство наших приложений использует компоненты ActiveX. Поскольку у нас используется OpenShift, наши Docker-контейнеры работают на RedHat Enterprise Linux. Таким образом, встает вопрос: как запустить Internet Explorer в Docker-контейнере, когда хостовая машина у нас на Linux? TroubleshootingВ заключение мы хотели бы поделиться с вами решениями некоторых проблем, с которыми столкнулись в процессе развертывания и настройки кластера.

Следующий кейс — работа с S3 совместимым хранилищем. Moon умеет записывать то, что происходит в контейнере с браузером. На одной ноде вместе с браузером поднимаются сервисные контейнеры, один из которых — это видеорекордер. Он записывает все, что происходит в контейнере и после окончания сессии отправляет данные в S3 совместимое хранилище. Чтобы отправлять данные в такое хранилище, нужно указать в настройках url, пароли-явки, а также название корзины. И напоследок...Каждый контейнер с браузером можно настроить самостоятельно — все доступные параметры есть в документации Moon. Обратим внимание на такие кастомные настройки, как privileged и nodeSelector.

Куда мы стремимся

|