Что пишут в блогах

- Перестать лайкать лайки

- Питер Сенге. Пятая дисциплина. Искусство и практика обучающейся организации

- Итоги 2025 года (родилась дочка, конференции, курс по ChatGPT)

- ChatGPT, подсчитай количество страниц в книге и авторских листов

- Вайб-кодинг и вайб-тестинг — полный гайд на реальных проектах в Cursor и ChatGPT

- Новогодний QA квиз

- Не просри свое время

- Гуру на Урале 4 декабря

- Мои 12 недель в году. Часть 32 (ДР Влада и мой, болезни...)

- Опрос удовлетворенности работой 2025

Что пишут в блогах (EN)

- Things which were not on my 2025 bingo card

- 2025 - The Year in Review

- User Error

- Dis Is Weird

- Software Testing Weekly – 294th Issue

- IEEE Report: How IT Managers Fail Software Projects

- Agile Testing Days 2025 - Taking Things Easier

- Observations of a habit transformation

- Agile Testing Days – 2025

- Alun Turing FTW

Онлайн-тренинги

-

Автоматизатор мобильных приложенийНачало: 29 января 2026

-

Школа для начинающих тестировщиковНачало: 29 января 2026

-

Автоматизация тестирования REST API на PythonНачало: 29 января 2026

-

Тестирование мобильных приложений 2.0Начало: 29 января 2026

-

Тестирование безопасностиНачало: 29 января 2026

-

Python для начинающихНачало: 29 января 2026

-

Азбука ITНачало: 29 января 2026

-

Автоматизация тестирования REST API на JavaНачало: 29 января 2026

-

Автоматизация функционального тестированияНачало: 30 января 2026

-

Тестирование REST APIНачало: 2 февраля 2026

-

Тестировщик ПО: интенсивный курс (ПОИНТ) со стажировкойНачало: 3 февраля 2026

-

Школа тест-менеджеров v. 2.0Начало: 4 февраля 2026

-

Инженер по тестированию программного обеспеченияНачало: 5 февраля 2026

-

Автоматизация тестов для REST API при помощи PostmanНачало: 5 февраля 2026

-

Применение ChatGPT в тестированииНачало: 5 февраля 2026

-

Тестирование веб-приложений 2.0Начало: 6 февраля 2026

-

Аудит и оптимизация QA-процессовНачало: 6 февраля 2026

-

Школа Тест-АналитикаНачало: 11 февраля 2026

-

Docker: инструменты тестировщикаНачало: 12 февраля 2026

-

Регулярные выражения в тестированииНачало: 12 февраля 2026

-

Git: инструменты тестировщикаНачало: 12 февраля 2026

-

SQL: Инструменты тестировщикаНачало: 12 февраля 2026

-

Chrome DevTools: Инструменты тестировщикаНачало: 12 февраля 2026

-

Bash: инструменты тестировщикаНачало: 12 февраля 2026

-

Программирование на C# для тестировщиковНачало: 13 февраля 2026

-

Логи как инструмент тестировщикаНачало: 16 февраля 2026

-

Техники локализации плавающих дефектовНачало: 16 февраля 2026

-

Charles Proxy как инструмент тестировщикаНачало: 19 февраля 2026

-

CSS и Xpath: инструменты тестировщикаНачало: 19 февраля 2026

-

Тестирование GraphQL APIНачало: 19 февраля 2026

-

Программирование на Python для тестировщиковНачало: 20 февраля 2026

-

Selenium IDE 3: стартовый уровеньНачало: 20 февраля 2026

-

Практикум по тест-дизайну 2.0Начало: 27 февраля 2026

-

Тестирование производительности: JMeter 5Начало: 27 февраля 2026

-

Организация автоматизированного тестированияНачало: 6 марта 2026

-

Программирование на Java для тестировщиковНачало: 6 марта 2026

-

Тестирование без требований: выявление и восстановление информации о продуктеНачало: 9 марта 2026

-

Создание и управление командой тестированияНачало: 19 марта 2026

| Тестирование производительности для чайников |

| 05.07.2017 09:53 |

|

Автор: Лукас Розуонек (Łukasz Rosłonek) Перевод: Ольга Алифанова Я заметил, что большинство тестировщиков слабо знакомо с такой областью, как тестирование производительности. В основном мы концентрируем усилия на функциональных аспектах тестирования, оставляя тестирование производительности, масштабируемости и настройки на откуп разработчикам. Но ведь стабильность – важная часть качества продукта, особенно в эпоху распределенных сетей, когда приложения масштабируются независимо и опираются на интеграцию через HTTP-протоколы. Другой аспект качества – способность увеличивать масштаб наших систем. Для того, чтобы справиться с ростом трафика, нужно знать пропускную способность ПО. Инженеры хорошо знакомы с такими инструментами, как JMeter, Gatling, Tsung. Они относительно просты в использовании, но люди зачастую плохо разбираются в анализе выданных ими результатов, и не умеют делать выводы на их основании. Собеседуя кандидатов на должность тест-инженера, я часто встречаю людей, утверждающих, что они имеют опыт тестирования производительности, но не владеющих знаниями о метриках этого вида тестирования, а также о его элементарных положениях. Основная цель нагрузочного тестирования и тестирования производительности – не умение обращаться с соответствующими инструментами, а знания, полученные в результате их использования. Цель этой статьи – осветить основные аспекты этой области.

Тестирование производительности и нагрузочное тестирование Люди зачастую путают нагрузочное тестирование и тестирование производительности. Два этих термина часто используются, как взаимозаменяемые, но это вовсе не так. Цель тестирования производительности – это поиск "бутылочных горлышек" системы или архитектуры. Как говорится, скорость нашей системы – это скорость самого медленного ее компонента. Предположим, что система состоит из нескольких различных микросервисов. У каждого из них есть собственное время отклика и устойчивость к нагрузке. Добавим сюда такие факторы, как тип базы данных, сервера или местоположение дата-центра. Пользователям приложения нужен быстрый отклик системы и ее высокая доступность. Тестируя производительность, мы ищем узкие места в нашей архитектуре и независимо масштабируем и настраиваем микросервисы, чтобы добиться вышеупомянутого быстрого отклика системы целиком. А вот доступность системы оценивается при помощи нагрузочного тестирования. Если в трех словах, тестировать нагрузку – это испытывать нашу систему на прочность при помощи большого количества пользователей или подключений, нагружать ее. Мы постоянно увеличиваем это количество, чтобы определить максимально возможное количество задач, с которым наша система справится. Нагрузочные тесты особенно важны при релизе нового сервиса и проверке, соответствует ли он предположительному трафику. Эти два вида тестирования, хоть и похожие по своей природе и способу проведения тестов, очень различаются в плане анализа результатов и реакции системы. Время ожидания, пропускная способность и ширина канала Как уже говорилось, самое важное в тестировании производительности и нагрузки – это анализ полученных данных. Для его проведения нужно знать основные метрики производительности. В современном мире сетевых коммуникаций очень важно замерять время ожидания, пропускную способность и ширину канала.

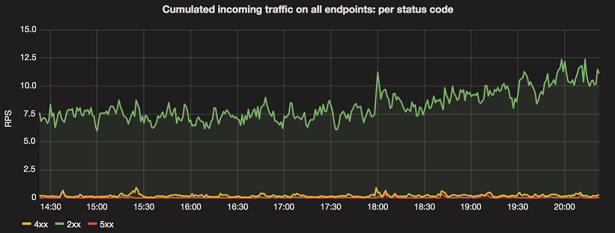

Ширина канала – как правило, величина постоянная (в течение определенного времени). Поэтому очень важно анализировать время ожидания и пропускную способность совместно, потому что эти метрики дают вам ясное представление о производительности системы. Перцентили При измерении времени ожидания одним из первых приходящих в голову сценариев будет расчет среднего времени ожидания за определенное время. Первым измеряемым показателем будет арифметическое среднее, однако здесь есть некоторая проблема: арифметическое среднее очень чувствительно к большому среднеквадратичному отклонению. Так как графики времени ожидания обычно довольно равномерны с небольшими экстремумами, лучше использовать перцентили. Если вы хотите замерить среднее время ожидания вашего сервиса, то можно использовать медиану – 50-й перцентиль (p50). Однако следует помнить, что p50 тоже чувствительно к статистическим флуктуациям. Наиболее распространенная метрика для замера среднего времени ожидания – это 90-й и 99-й перцентили (p90 и p99). К примеру, если время ожидания для p90 составляет 1 мс, то это означает, что в 90% случаев ваш сервис отвечает спустя 1 мс. Частота ошибок Как уже говорилось, мы можем измерить объем полученного трафика, замеряя пропускную способность, однако что насчет исходящего трафика – ответов приложения? Важно знать, какими HTTP-кодами мы отвечаем на запросы – 2хх, 4хх или 5хх. И тут в игру вступает измерение частоты ошибок. Цель этого измерения – узнать, сколько (какой процент) наших ответов успешны, и тому подобные вещи. Какая-то часть исходящего трафика всегда будет с ошибкой (в том числе из-за валидации клиентами – коды 4хх). Однако если в частотности ошибок возникают внезапные пики, это может означать, что в приложении проблемы. Пример графика частоты ошибок приведен на изображении выше. Заключение В последнее время я заметил, что многие тест-инженеры осваивают инструменты тестирования производительности, не имея базовых знаний об этой области тестирования. Чтобы эффективно работать над масштабируемостью и профилированием системы, нужно осознавать, что именно необходимо замерять, и только потом переходить к вопросу, как. |

Оригинал статьи:

Оригинал статьи: